Pewien youtuber przeprowadził eksperyment ze ścianą stojącą na drodze, którą pomalowano w taki sposób, by przypominała biegnącą dalej drogę. Niektórzy twierdzili, że była to porażka FSD – ale niezupełnie, samochód nie miał aktywnego FSD. Youtuber chciał doprowadzić do zderzenia na Autopilocie i… też nie do końca mu się udało, bo mechanizm wyłączył się tuż przed ścianą. W tych warunkach najlepiej poradziłby sobie lidar, może też radar.

Widowiskowy eksperyment, wielka kłótnia i ciekawe wnioski

Film pod tytułem Can you fool self driving car? / Czy możesz oszukać samochód autonomiczny? w ciągu zaledwie dwóch dni zebrał prawie 13 milionów wyświetleń, bo eksperyment jest frapujący. Otóż youtuber Mark Rober postawił na drodze ścianę-drogę. Chciał sprawdzić, czy Tesla jadąca na Autopilocie przed nią zahamuje, czy się z nią zderzy, czy może wydarzy się coś innego. Interesowało go, czy „proste kamery” Tesli mogą odpowiadać „droższej/zaawansowanej technologii”. Oto ściana i nagranie, gdyby ktoś chciał obejrzeć całe wideo, bo eksperymentów jest na nim kilka:

W internecie błyskawicznie rozgorzała wielka kłótnia. Youtuberowi wytknięto, że współpracuje z producentem lidarów, że już na etapie edycji przemalował jeden z telefonów z iPhona na Pixela, bo bierze pieniądze od Google, i „ciekawe, co jeszcze przerobił”. Pojawiły się też głosy o „upadku FSD”, najczęściej formułowane przez tych, którzy przeczytali tylko tytuł filmu, bez jego oglądania, bo zaraz na początku pojawia się wzmianka o sprawdzeniu możliwości Autopilota Tesli i jego „prostych kamer”. A w rzeczywistości: systemów noszących zbiorczą nazwę ADAS (pol. Zaawansowane Systemy Wspomagania Kierowcy).

Jednak to wszystko to w rzeczywistości drobnostki, ponieważ Autopilot… wyłączył się tuż przed ścianą. Właściciel kanału mówi, że nie wie, dlaczego tak się stało. Niektórzy internauci sądzą, że jest to efekt mocnego uchwycenia kierownicy (duży moment na kole), inni utrzymują, że Tesla „coś zobaczyła”. Jeśli wierzyć oświadczeniom producenta, takie zdarzenie mimo wszystko zostałoby uznane za błąd Autopilota. W dodatku auto nie zwalniało po uderzeniu (rekuperacja), nawet lekko przyspieszyło:

Okazuje się, że zwykłe systemy rozpoznawania obrazów już na podstawie pojedynczej klatki zauważają, że mają do czynienia z pomalowaną przeszkodą a nie z drogą. I znowu trzeba zastrzec, że analiza dotyczy klatek widzianych przez iPhona (nagranie), a nie przez kamery Tesli. Z drugiej strony: ściana mogłaby zmylić nawet człowieka, są przypadki kierowców, którzy usiłowali wjechać do namalowanych na ścianie tuneli (embed numer 2):

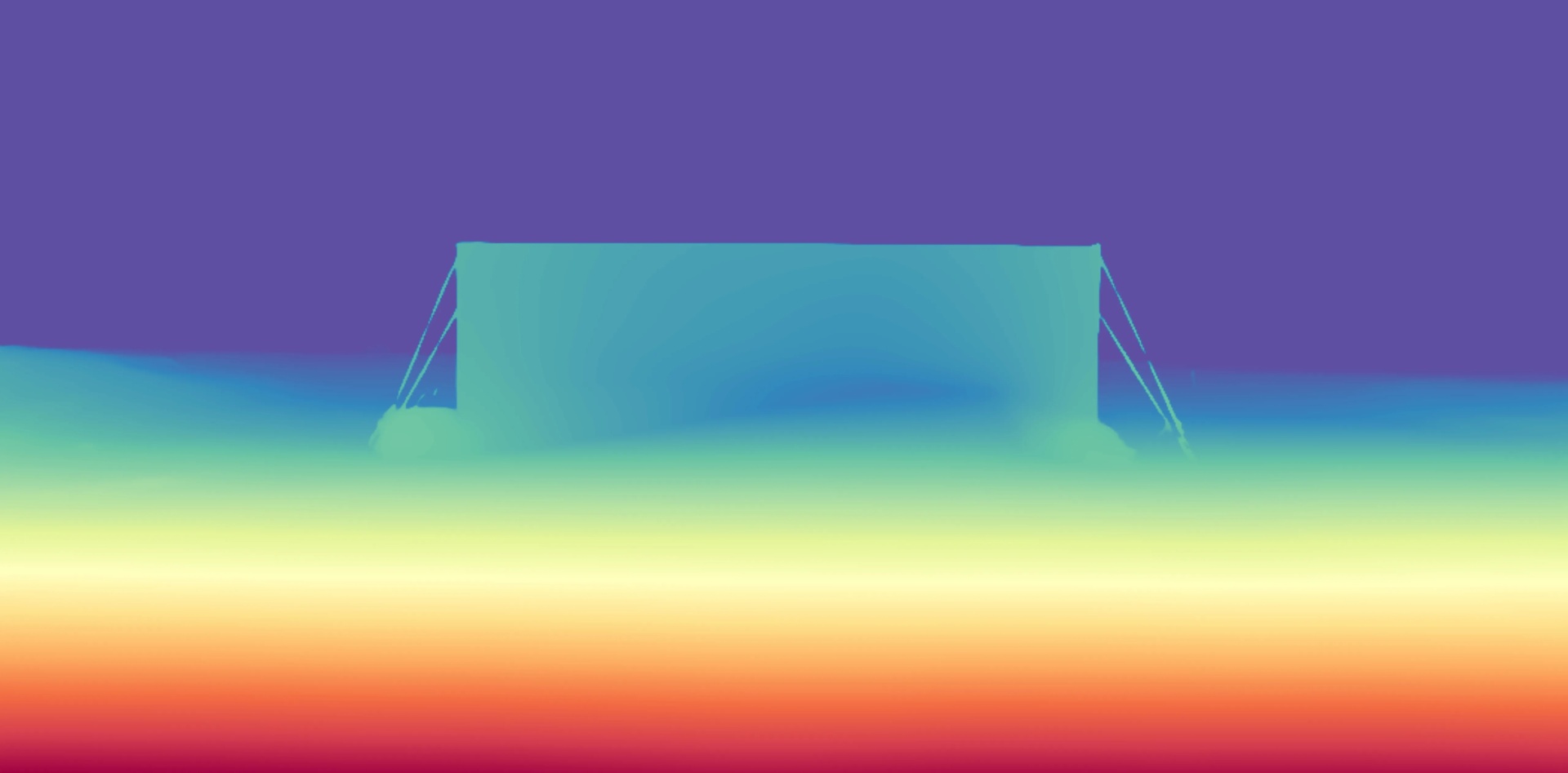

after running the road runner scenario through a monocular depth estimation model (that probably has much less accuracy than the real FSD system would have). pic.twitter.com/I5EFZB2914

— abdou (@thatabdou) March 17, 2025

so i’m doing research on if there are any fake roads painted on walls in the LA area and it turns out people actually crash into these things a lot pic.twitter.com/GDmrlkJXdq

— Whole Mars Catalog (@WholeMarsBlog) March 17, 2025

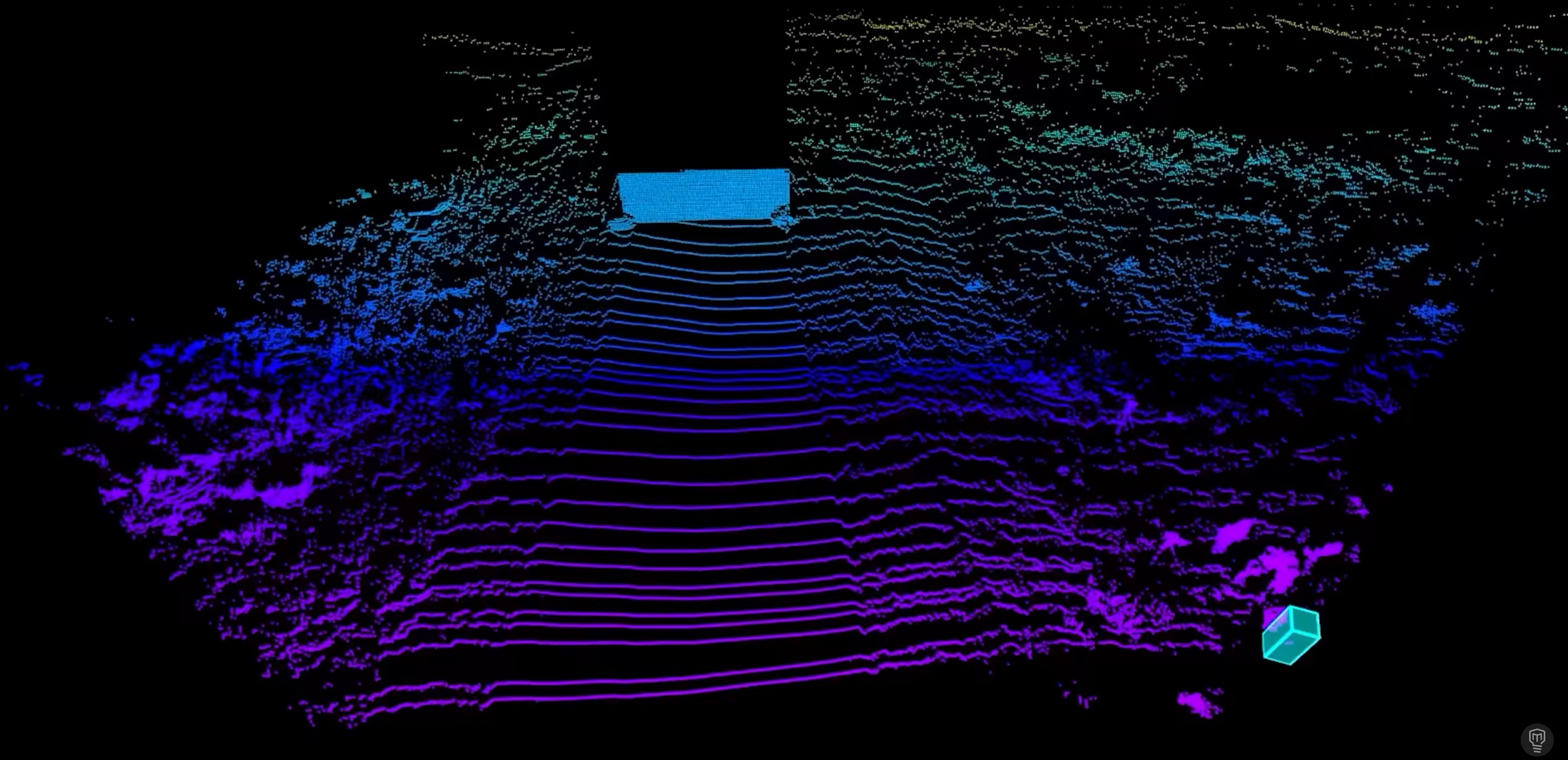

Tym niemniej faktem jest, że kamery mają ograniczenia zbliżone do ludzkich oczu: mogą nie widzieć czegoś, co jest, albo widzieć coś, czego nie ma. W sytuacji z filmu najlepiej poradziłby sobie lidar, bo laser dostrzegłby stojącą na drodze przeszkodę (ilustracja poniżej). Dobrze mógłby poradzić sobie też radar, o ile tylko styropian dałby wystarczające echo.